Juridik i förhållande till AI

Vissa rättsliga frågor aktualiseras oftare när det kommer till AI än vid annan användning av digital teknik. Ofta är de relaterade till användningen av data. Snart kommer det sannolikt även att finnas en EU-gemensam AI-förordning att ta hänsyn till – den förhandlas för närvarande inom EU. Om förordningen blir beslutad kommer en rättslig defintion av AI att finnas. I dagsläget saknas en sådan definition men den här texten utgår från den föreslagna definitionen av AI i förordningen. Därmed används AI-system, i enlighet med AI-förordningen som synonymt med AI. Med detta sagt är det alltid viktigt att verksamheten definerar och har en tydlig beskriving av det AI-system verksamheten avsett använda och att verksamheten är tydlig hur AI-systemet är avsett att användas.

De rättsliga frågeställningarna när AI används i offentlig sektor är dock sällan särskilt annorlunda eller speciella jämfört med exempelvis annan it-utveckling. Det finns ett antal lagar och regler som särskilt gäller AI. Det viktigaste är dock att ha förståelse för och kunna tillämpa de regler som alltid gäller för och styr offentlig förvaltning även i arbetet med att utveckla AI-tillämpningar. eSAM har tagit fram en checklista som är användbar för analysen.

I likhet med annan verksamhet är det viktigt att ha ett tvärfunktionellt samarbete vid utvecklande av AI-lösningar och juridisk kompetens bör tidigt involveras. De som besitter den juridiska kompetensen behöver även ha tillräcklig förståelse för både den teknik som ska användas och den verksamhet som den ska användas i. Det är också viktigt att utgå från de behov som ska mötas och verksamhetsmålen. Detta kommer inte bara att avgöra om AI är rätt verktyg, utan också vilka regler som styr användandet.

Juridik och etiska principer i förhållande till AI

Det är vanligt förekommande att etik nämns i samband med användningen av AI. För offentlig sektor ger regeringsformen oss utgångspunkten för de etiska värdena som ska upprätthållas i all offentlig verksamhet. För statliga myndigheter förtydligas dessa värden i den statliga värdegrunden: demokrati, legalitet, objektivitet, fri åsiktsbildning, respekt samt effektivitet och service. Den statliga värdegrunden är också relevant för kommuner och regioner.

Enligt den svenska inriktningen för AI ska ett genomgående tema för AI vara hållbar AI, med innebörden att AI-applikationer bör vara etiska, säkra, pålitliga och transparenta. Den statliga värdegrunden för offentlig verksamhet och inriktningen mot hållbar AI bör därför vara utgångspunkt om det tas fram andra etiska ramverk eller liknande för användning av AI inom det offentliga. Etiska uppförandekoder eller liknande, som inte tydligt utgår ifrån de ramverk som är demokratiskt beslutade bör undvikas för offentlig sektor då verksamheten är rättsligt reglerad. För allmänheten behöver det vara tydligt på vilka rättsliga grunder beslut fattas.

Ibland uppstår det målkonflikter mellan värden enligt den statliga värdegrunden, något som särskilt kan uppstå när en myndighet försöker lära en AI att göra det som tjänstepersoner tidigare har gjort. Avvägningar som tidigare har gjorts av en tjänsteperson ska istället programmeras och avvägningarna behöver då tydliggöras och hanteras på ett transparent sätt. Ett stöd för bidra till transparens och för att belysa att verksamheten har rätt förutsättningar på plats kan vara att använda sig av förtroendemodellen som finns på offentligai.se.

”Stöd att inte äventyra tilliten till offentlig förvaltning”

Fyra frågor till David Magård, strateg på Bolagsverket, om den förtroendemodell som vidareutvecklats under det nationella AI-uppdraget.

Varför behövs en förtroendemodell?

Förtroendemodellen ger offentliga aktörer stöd i sitt arbete att utveckla och använda AI-lösningar som är etiska, säkra, pålitliga och transparenta. DIGG och Lantmäteriet fick 2019 ett regeringsuppdrag att utveckla en förtroendemodell. Vi på Bolagsverket har sedan tillsammans med Arbetsförmedlingen, Skatteverket och DIGG fått ett nytt regeringsuppdrag där en delleverans varit att vidareutveckla den.

Vad är nytt i den nya versionen?

Förtroendemodellen som tillgängliggörs i dataportalen/Offentlig AI i januari 2023 är utvecklad innehållsmässigt och för att vara användarvänlig. Vi har fört dialoger med forskare och andra experter på AI och tillitsfrågor. I den nya versionen har vi generaliserat frågeställningarna och jobbat för att modellen ska vara mer lätthanterlig.

Hur kan förtroendemodellen användas och av vem?

Modellen hjälper offentliga aktörer att på ett systematiskt sätt gå igenom relevanta frågor när de vill använda eller utveckla lösningar baserade på AI. Det kan till exempel handla om rättsliga frågeställningar eller hur data behandlas. Tanken är att man svarar på frågor tillsammans, med flera olika kompetenser i gruppen, vilket är viktigt för att inte missa viktiga perspektiv. Det säkerställer att den offentliga aktören fattat medvetna beslut om transparens och integritetsfrågor när AI används och att det dokumenteras. Därmed går det som medborgare att få insyn om att myndigheter arbetat systematiskt och genomtänkt när de utvecklat AI. För en tillsynsmyndighet underlättar det då det gjorts en genomgång av viktiga moment och det finns en dokumentation av det.

Vad är nästa steg?

Förtroendemodellen kommer vara under fortsatt utveckling. Det är först nu när den börjar användas som vi kommer se hur den kan förbättras än mer. AI är ett område som är i ständig rörelse, det kommer nya riktlinjer och regler som exempelvis den europeiska AI-förordningen. En framtida version av förtroendemodellen kan sannolikt ge ännu mer stöd för att hamna rätt gentemot den.

Rättsliga frågor i olika utvecklingsfaser

Beroende på var i arbetet ni befinner er, kan tyngdpunkten i den juridiska analysen och bedömningen ligga på olika frågor.

I den inledande fasen är det vår erfarenhet att fokus brukar och bör vara att:

- bedöma de data som ska användas, däribland personuppgiftsfrågor och om det finns rättslig grund för användningen av de data som önskas använda,

- ta ställning till juridiska frågor kring att utveckla egna tekniska lösningar eller att köpa färdiga modeller. Olika val kopplat till tekniska lösningar påverkar vilka rättsliga frågeställningar som blir centrala.

För att AI-lösningar ska kunna användas på ett legitimt sätt i offentlig förvaltning är det centralt att analysera om det är lämpligt och tillåtet att använda data på nya sätt och om datamängderna håller en tillräcklig kvalitet. Det är därför vår erfarenhet att den utforskande fasen kommer att vara längre för AI-tjänster än vid utveckling av andra it-tjänster.

Förvaltningslagen relevant för all offentlig verksamhet

I förvaltningslagen (2017:900) finns det ett antal regler som måste hanteras även i förhållande till en AI-tillämpning. Det kommer att variera vilka regler som är aktuella beroende på vilken typ av AI-system som myndigheten ska utveckla eller använda. Användandet av en AI-tillämpning får inte innebära att enskilda människor får det svårare att kommunicera eller komma i kontakt med myndigheten jämfört med annars.

De flesta regler i förvaltningslagen som är relevanta har att göra med hur myndigheten ska utreda och fatta beslut i ett ärende. En central fråga för att avgöra vilka rättsliga frågor som behöver hanteras är om ett AI-system ska fatta automatiska beslut, eller om AI-systemet endast ska användas som ett stöd i handläggning av ärende. Huvudregeln är att statliga myndigheter, kommuner och regioner får fatta automatiserade beslut men undantag kan finnas bl.a. i registerförfattningar. Om ett AI-system tar fram rekommendationer till beslut som myndigheten i praktiken alltid följer, går det att ifrågasätta om det verkligen är myndighetens tjänstepersoner som fattar besluten, var gränsen går har dock inte prövats rättsligt.

Förvaltningslagen överlåter på myndigheten att bestämma hur ärenden ska utredas, baserat på hur ärendet ser ut. Det innebär att förvaltningslagen inte direkt ställer några krav på kvalitet hos ett AI-system, utöver vad en myndighet bestämmer är tillräcklig för att myndigheten ska kunna utföra sina uppgifter. Användningen av AI-system måste dock som minimum motsvara de allmänna krav på god förvaltning som beskrivs i förvaltningslagen 5-8 § - saklighet, opartiskhet och proportionalitet.

Vid utredningen av ärenden ska reglerna i förvaltningslagen 23-27 § följas. I 23 § första stycket anges: ” En myndighet ska se till att ett ärende blir utrett i den omfattning som dess beskaffenhet kräver.”

Detta innebär att AI-lösningen behöver vara utformat så att dessa grundläggande krav kan upprätthållas. Vad detta innbär konkret måste analyseras för varje AI-lösning i förhållande till vilken funktion den ska fylla. Ytterligare krav kan dock finnas i andra författningar.

Alla myndighetsbeslut går som huvudregel att överklaga. För att säkra rätten till en rättvis rättegång bör myndigheter kunna förklara hur ett AI-system fungerar på ett förståeligt sätt. Förklaringen behöver vara begriplig för enskilda i vars ärende ett AI-system har använts, de handläggare som använder AI-systemet samt andra relevanta aktörer som domstolar, tillsynsmyndigheter och intresseorganisationer.

Grundläggande principer i dataskyddsförordningen

I alla faser av arbete med ett AI-verktyg är det relevant att avgöra om personuppgifter behandlas. Om personuppgifter kommer att behandlas är dataskyddsförordningen tillämplig på alla delar av arbetet – från det utforskande stadiet av tillgänglig data, till träning av AI-tillämpningen och att hantera risken för snedvridning (bias control), till tillämpning av verktyget i driftfasen. Finalitetsprincipen, uppgiftsminimering, krav på att personuppgifter ska vara korrekta och nödvändighetskriteriet är alla principer som är relevanta för arbetet med AI.

Om AI-lösningen kommer att hantera data som är personuppgifter behöver man sannolikt genomföra en konsekvensbedömning som är en riskanalys för att förebygga risker för integriteten. Vägledning om när en sådan måste genomföras och mall finns på Integritetsskyddsmyndighetens webbplats. Art. 35 dataskyddsförordningen pekar ut vissa typer av behandlingar av personuppgifter som särskilt riskfyllda. Bland dessa finns automatiserade beslutsstöd och användning av ny teknik.

Registerförfattningar för myndigheter viktiga vid datahantering

Något som kopplar till både myndighetens uppdrag och till dataskyddsförordningen är eventuella registerförfattningar som finns för en myndighet. Sådana författningar reglerar typiskt sett vilka personuppgifter som en myndighet får behandla och för vilka ändamål det får ske. Det kan också finnas begränsningar rörande hur personuppgifter får sammanställas och regler för hur behörigheter till personuppgifter ska tilldelas. Registerlagar preciserar alltså ytterligare det handlingsutrymme som en myndighet har med personuppgifter och kompletterar övrig lagstiftning på dataskyddsområdet.

Det blir centralt för en myndighets AI-arbete att bedöma sin planerade tillämpning av AI i ljuset av registerlagar, om AI-arbetet ska använda data om personuppgifter. Det kan finnas situationer där sådan lagstiftning helt förhindrar insamling av personuppgifter på det sätt som behövs för att nå tillräckligt hög kvalitet i den data som en AI behöver. Det är därför viktigt att undersöka detta redan i det utforskande stadiet av arbetet, och det gäller oavsett om arbetet ska förlita sig på data som myndigheten redan har, eller om nya data ska samlas in.

Diskrimineringslagen

Vid utveckling av AI-lösningar har frågor om risker för snedvridning (bias) som kan leda till diskriminering fått mycket uppmärksamhet. Risker för diskriminering vid AI-användning kan uppstå pga. bristande kvalitet i data, bristande träning av AI och bristande transparens på grund av så kallade ”svarta lådor”. Brister i data kan utgöra en risk för diskriminering genom att nödvändiga data saknas eller att data som används inte återspeglar faktiska förhållanden utan har påverkats av snedvridning (bias) redan vid insamling. Data kan återspegla historisk diskriminering och därmed reproducera den. Data kan också tolkas på ett sätt som leder till risk för diskriminering. Brister i träning kan föreligga när inmatade data innehåller en snedvridning (bias) och inlärningsalgoritmen därmed tränar en modell som diskriminerar. Brist på transparens innebär en risk för att diskriminering inte upptäcks.

Frågor kopplat till snedvridning är viktiga att inkludera i alla faser av utveckling och användning av AI-lösningar inom offentlig förvaltning (och annars). Diskrimineringsombudsmannen arbetar med frågor kopplat till detta och har publikationer om hur myndigheter hanterar diskriminering i förhållande till automatiserat beslutsfattande, oavsett om det beslutsfattandet använder sig av AI eller inte.

Upphandling och konkurrensfrågor

Om en myndighet väljer att upphandla och köpa in ett AI-verktyg finns det ett antal saker att reflektera över, utöver de vanliga upphandlingsrättsliga frågorna.

Vid införskaffande av teknik, system eller lösningar med AI kan det bli fråga om en mer rörlig leverans än vid traditionell anskaffning. Det kan därmed behöva övervägas hur lämpliga krav kan ställas på garantier att AI-modellen är utvecklad med hänsyn till etik och med objektivitet och saklighet som grund vid träning, test och verifiering samt i avtalet reglera ansvaret för AI-specifika fel och lämpliga påföljder vid avtalsbrott. Det är också viktigt att reglera granskningskriterier för att kunna granska leverantörens AI-teknik och bedöma denna utifrån de egna kraven och kontraktsuppfyllnad. Hur detta görs bäst måste myndigheten ta ställning till utifrån det verktyg och användningsområde som förutses.

Vid anskaffning av AI-programvara behöver den upphandlande organisationen även säkerställa att den förädlade AI-modellen ingår i användarlicensen alternativt tillfaller myndigheten med äganderätt. Ingår träningsdata i leveransen bör även denna materia regleras i avtalet, även om data i sig inte är en immaterialrättsligt skyddad tillgång. Dessutom kan data utgöra s.k. nödvändiga nyttigheter (essential facilities) som enligt konkurrensrätten kan ge en monopolliknande ställning för innehavaren.

På andra platser i den här guiden påtalas vikten av transparens. I samband med detta finns frågor som är viktiga om ni väljer att köpa in så kallade proprietära AI-verktyg. Det förekommer att företag vill reglera skydd för sitt AI-verktyg i avtalen utanför vad som gäller för immaterialrättsligt skydd. Som myndighet är det dock viktigt att säkerställa att avtalsvillkor som ska skydda affärshemligheter eller dylika intressen hos leverantörer inte får leda till att myndigheten får sämre kunskap om hur verktyget fungerar, eller göra att myndigheten inte kan upprätthålla transparensen mot t.ex. enskilda eller domstolar. Det är därför viktigt att kontrollera vad som gäller för konfidentialitet och spridning av information om AI-verktygets funktion så att det är godtagbart ur ett myndighetsperspektiv.

Det är också viktigt att tänka på hur myndigheten påverkas av att göra sig mer beroende av ett AI-verktyg som utför en delmängd av de bedömningar som tidigare har gjorts av handläggare. Det kan få omfattande påverkan på verksamheten när avtalen löper ut, eller om det uppstår problem i förhållande till leveransen av AI-verktyget. Det är inte ovanligt att stora resurser och tid har investerats i träning av AI-modellen som riskerar att gå förlorade vid avtalets upphörande. Det behöver därmed beaktas vid avtalets ingång vad som är en lämplig reglering vid exit.

Offentlighetsprincipen och vad som är allmän handling

Det skiljer sig inte så mycket vid användning av AI-lösningar när det gäller hur en myndighet ska hantera allmänna handlingar. I alla led av AI-verktygets livscykel kommer det sannolikt att uppstå allmänna handlingar, och en myndighet behöver avgöra hur dessa ska hanteras. Inte minst kommer allmänna handlingar uppstå som en konsekvens av den tekniska dokumentation som AI-förordningen föreskriver ska finnas.

Det kan vara klokt att tidigt i utvecklingsarbetet undersöka om det kommer att genereras handlingar i AI-lösningen som ska förtecknas i diariesystem eller som behöver kunna bevaras i ett e-arkiv. Då behöver man till exempel definiera vilken data som kan betraktas som färdiga ”handlingar” och även säkerställa att det är möjligt att tekniskt bevara informationen så att den blir läsbar över tid.

AI-förordningen

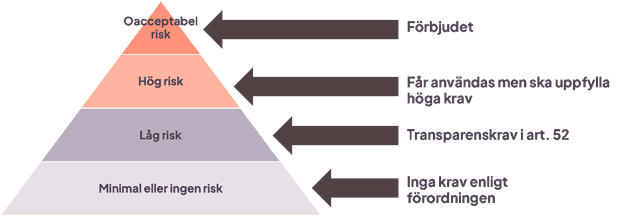

AI-förordningen förhandlas inom EU vid tidpunkten för denna version av AI-guiden. AI-förordningen är ett omfattande regelverk som syftar till att reglera användningen av AI inom EU utifrån ett riskbaserat angreppssätt. AI-förordningen kommer att reglera användning av sådana ”AI-system” som faller inom definitionen i förordningen. Första steget kommer därför att vara att analysera om den AI-lösning som planeras faller inom AI-förordningens tillämpningsområde.

Det riskbaserade regelverket innebär att vissa AI-system blir förbjudna, andra – som för med sig hög risk för kränkningar av individers säkerhet och fri-och rättigheter – får bara användas om de uppfyller ett stort antal krav. För vissa AI-system som faller utanför de kategorierna finns det krav på transparens (att det tydligt ska framgå att AI används).

Förordningen är tillämplig på system från det att de ”tas ut på marknaden”. Detta bör i praktiken innebära när de är i faktisk användning, oavsett vem som utvecklat dem. AI-system som är i fasen forskning- och utveckling är således undantagna.

För offentlig sektor kan det förväntas att AI ofta kommer att användas inom områden som enligt AI-förordningen räknas som hög risk. Verksamheten som använder ett AI-system, oavsett om det är egenutvecklat eller upphandlat eller båda och i delar, som är att klassa som hög risk kommer att behöva ta hänsyn till ett stort antal krav på bl.a. dokumentation.

När AI-förordningen är beslutad kan stödet för offentlig förvaltning i AI-guiden uppdateras.

”Diskussion är en nyckel för hållbar AI”

Fyra frågor till Josephine Brofjorden, strateg på Skatteverket som varit med och skapat riktlinjer och ett råd för hållbar AI.

Hur arbetar ni med hållbar AI?

När vi tog fram en policy kring AI ville vi också konkretisera vårt arbete för att säkerställa att den AI som utvecklas och används vid Skatteverket är hållbar. Vi ville ha riktlinjer, men också en arbetsprocess, och här landade vi i att skapa ett råd för hållbar AI. En väldigt viktig utgångspunkt i arbetet är den statliga värdegrunden. Vi ska i vårt arbete med AI vara ansvarstagande, transparenta och kunna förklara vår AI - och i ansvarstagandet ingår en hög efterlevnad av den statliga värdegrunden.

Hur arbetar rådet?

Rådet är ett objektivt tvärfunktionellt forum för diskussion. Rådet ger en serie konsultationer – från tidig tanke på AI till uppföljning. Vi har varit igång i pilotform sedan 2021. Hittills uppstår den största nyttan när verksamheten, dvs. de som beställer lösningen och kommer att äga den, har en aktiv roll och konsulterar rådet i ett tidigt skede. I den första konsultationen diskuterar vi om och hur AI kan vara en bra väg framåt. I det här tidiga skedet funderar vi inte över detaljer och exakta parametrar, utan resonerar oss fram kring: vilka konsekvenser kan olika val få?

Vilken typ av frågeställningar diskuteras?

Ofta handlar det om integritetsfrågor. Vi har till exempel diskuterat en lösning där medarbetare som arbetar med utveckling skulle kunna få stöd i arbetet av en bott som identifierar behov av olika stödfunktioner. Här resonerade vi om eventuell känsla av integritetskränkning – att bara för att man skriver en viss sak så erbjuds man hjälp av botten. Juridiskt sett skulle det kunna vara fullt lagligt med en sådan bott, men hur blir känslan? Här blir designen avgörande, t.ex. angående vem informationen går till, till medarbetaren som skriver eller till stödfunktionen etc.

Ett annat exempel är hur vi kan värdera och använda information som hämtas från internet, utifrån ett användarfall där man ville använda den typen av data i en AI-lösning. Det finns situationer när en källa inte kan användas som faktaunderlag, men skulle den kunna användas som indikation för att söka mer information? Här handlar det om bedömningar av en källas tillförlitlighet i relation till hur informationen används. Även här blir designen viktig så att vi stödjer medarbetarna att fortsätta vara källkritiska, som att i tjänsten tydligt berätta om källor och kvalitet på data. Vi har också haft många diskussioner om tänkbara risker och konsekvenser av olika lösningar för grupper som omfattas av diskrimineringsgrunderna.

Vilka kompetenser behöver ingå i den här typen av råd?

Vi har gått in för att vara en tvärfunktionell grupp och har kompetens inom flera olika områden: teknik, juridik, verksamhet, kommunikation. Men lika viktigt som att vara blandade funktioner är att vara blandade personer. I väldigt hög grad handlar det om att gruppen har förmåga att representera olika typer av perspektiv. Vi försöker vara så heterogena som möjligt och blanda ålder, kön och bakgrund. Det ökar möjligheten att se på en fråga ur olika personers synvinkel.